PythonでHTML読み込み、Webページをデータとして活用!📑

Pythonを用いることで、HTMLの読み込みやWebページからのデータ抽出が効率的に行えます。現代の情報化社会では、ウェブ上の膨大なデータを活用することが重要な競争力となっています。Pythonの豊富なライブラリ群、特にBeautifulSoupやrequestsといったツールを使えば、複雑なHTML構造から目的の情報を簡単に取得可能です。本記事では、これらの手法を詳しく解説し、どのようにWebページをデータとして活用するかを実践的に紹介します。プログラミング初心者でも理解しやすい内容を目指し、ステップバイステップで進めますので、ぜひ最後までお読みください。

Pythonを用いたHTMLの読み込みとWebデータ活用の方法とは?

PythonでHTMLを読み込み、Webページから情報を抽出してデータとして活用するためには、いくつかの重要なステップや手法があります。以下のセクションでは、その詳細について説明します。

1. PythonでHTMLを解析するためのライブラリとは?

PythonでHTMLを効率的に解析するために使用される主なライブラリには以下のようなものがあります:

- BeautifulSoup: HTMLやXMLファイルを簡単に解析できるライブラリで、タグの検索や内容の取得がスムーズに行えます。

- Requests: Webページを取得する際に利用され、レスポンスデータを簡単に操作できます。

- Selenium: 動的なWebページを操作するのに適しており、JavaScriptによって生成されるコンテンツにも対応可能です。

2. Webページのデータ抽出を行う手順

Webページから必要なデータを正確に抽出するには以下の手順が必要です:

- HTMLを取得: Requestsなどのライブラリを利用して、目的のWebサイトのHTMLコード全体を取得します。

- HTMLを解析: BeautifulSoupなどを使って、特定のタグやクラス、IDに基づいて情報を抽出します。

- データの整形: 取得したデータをリストや辞書形式に変換し、後続の処理で使いやすい形に整えます。

3. 動的Webページに対応するためのアプローチ

動的な要素を持つWebページでは、静的なHTMLだけでは情報が不足することがあります。そのためのアプローチは次の通りです:

- Seleniumの使用: JavaScriptがレンダリングするコンテンツもスクレイピング可能にするツールです。

- APIの利用: サイトが提供する公式APIを使用することで、動的なデータを直接取得できます。

- ヘッドレスブラウザ: バックグラウンドでブラウザを動作させ、人間と同じようにページをロードする仕組みです。

4. Webページのデータ分析における活用例

取得したWebページのデータは、次のような方法で分析や活用が可能です:

- トレンド分析: SNSやニュースサイトから定期的に情報を収集し、トピックスのトレンドを追跡します。

- 価格監視: オンラインショップの商品価格を自動で取得し、最安値を通知するシステムを構築します。

- 競合調査: 競合他社のサイトをモニタリングし、新製品やキャンペーン情報をリアルタイムで把握します。

5. スクレイピングにおける倫理と法的注意点

Webページのスクレイピングを行う際には、法律や倫理面での配慮が欠かせません。重要なポイントは以下の通りです:

- 利用規約の確認: 対象サイトの利用規約に従い、許可されている範囲内でデータを利用します。

- 過剰アクセスの回避: サーバーに負荷をかけないよう、リクエスト間隔を調整する必要があります。

- 個人情報の取り扱い: 個人情報が含まれる場合、適切な保護措置を講じる義務があります。

ウェブページのHTMLを取得するにはどうすればいいですか?

ウェブページのHTMLを取得するには、主に以下の方法が利用できます。これには、ブラウザの開発者ツールやプログラミング言語を使用する手法があります。

ブラウザの開発者ツールを使用してHTMLを確認する

ブラウザの開発者ツールは、ウェブページのHTMLを簡単に取得するための基本的な手段です。Google ChromeやFirefoxなどの主要なブラウザでは、この機能がデフォルトで提供されています。以下は手順です:

- 対象のウェブページを開く。

- 右クリックして「検証」または「要素の検証」を選択します。

- 表示されたHTMLコードをコピーまたは直接確認します。

PythonでrequestsとBeautifulSoupを使用してHTMLを取得する

プログラミングを使ってHTMLを取得する場合、PythonのライブラリであるrequestsとBeautifulSoupを使うのが一般的です。これにより、自動化された方法でデータ収集が可能です。手順は次の通りです:

- requestsモジュールを使用してウェブページにアクセスし、レスポンスを取得します。

- BeautifulSoupを用いてHTMLコンテンツを解析し、必要な部分を抽出します。

- エラーハンドリング(例: ステータスコードの確認)を追加し、安定した取得処理を実現します。

cURLコマンドを使用してHTMLを取得する

cURLはコマンドラインからHTTPリクエストを送信できるツールであり、ウェブページのHTMLを取得する際にも役立ちます。特にサーバーサイドでの作業やシェルスクリプト内で活用されます。使用方法は以下の通りです:

- ターミナルを開き、cURLコマンドを入力して実行します。

- 出力結果をファイルに保存する場合は、リダイレクト演算子「>」を使用します。

- 必要に応じてヘッダーやオプションを追加して、リクエスト内容をカスタマイズします。

PythonのWebスクレイピングとは?

PythonのWebスクレイピングとは、Webページからデータを自動的に収集し抽出するプロセスを指します。これは、ウェブサイト上の情報をプログラムによって解析し、必要なデータを取り出す手法です。主にBeautifulSoupやScrapy、Seleniumなどのライブラリやツールが使われます。

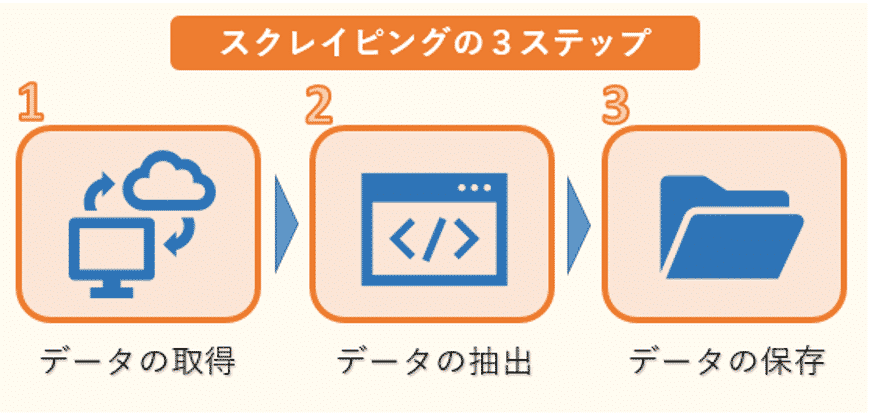

Webスクレイピングの基本的な仕組み

Webスクレイピングは、特定のURLにアクセスしてHTMLやCSSのコードを取得し、目的のデータを解析して抽出する方法です。以下はその基本ステップです。

- リクエストの送信: Pythonではrequestsライブラリを使ってサーバーにHTTPリクエストを送ります。

- HTMLの解析: 取得したHTMLデータをBeautifulSoupなどで解析し、タグやクラス名を利用して目的の情報を抽出します。

- データの保存: 抽出したデータをCSVやJSON形式でローカルに保存し、後続の分析や処理に利用します。

Webスクレイピングの活用事例

Webスクレイピングは幅広い分野で応用されています。特にマーケティングや研究、価格比較などでの利用が目立ちます。以下は代表的な活用例です。

- 競合価格の監視: オンラインショップの商品価格を定期的にスクレイピングし、競合他社との価格差を把握します。

- ソーシャルメディア分析: TwitterやInstagramのようなプラットフォームから投稿やハッシュタグを収集し、トレンドを分析します。

- ニュースの収集: 複数のニュースサイトから最新情報を自動的に取得し、まとめて管理します。

Webスクレイピングにおける注意点

Webスクレイピングには利便性がありますが、いくつかの倫理的および法的な問題にも留意する必要があります。以下の点に注意しましょう。

- robots.txtの確認: スクレイピング対象のサイトが提供するrobots.txtファイルを確認し、許可された範囲での操作を行います。

- 頻繁なアクセスを避ける: 短時間での大量リクエストはサーバーに負荷を与えるため、適切な間隔を開けてアクセスすることが重要です。

- 個人情報の取り扱い: 個人情報に関わるデータを無断で収集することはプライバシー侵害につながるため、慎重に対応します。

スクレイピングが禁止されているか確認する方法は?

スクレイピングが禁止されているか確認する方法は、主にウェブサイトの利用規約やロボット排除標準(Robots Exclusion Standard)を確認することです。これにより、運営者が許可している範囲や禁止事項について理解できます。

利用規約を確認する

ウェブサイトの利用規約には、データ収集に関する具体的なポリシーが記載されています。この文書を注意深く読むことで、運営者の意図を正確に把握できます。

- ウェブサイトのフッターやヘルプページから利用規約へのリンクを探します。

- 「スクレイピング」や「自動収集」などのキーワードで検索し、関連部分を確認します。

- 不明点がある場合は、直接運営者に問い合わせることを検討します。

robots.txtファイルを分析する

robots.txtファイルは、ーラーに対してどのページやディレクトリにアクセスして良いかを示しています。これを確認することで、スクレイピング制限を把握できます。

- 対象サイトのURLに「/robots.txt」と入力し、該当ファイルを表示します。

- Disallowと記載された行をチェックし、アクセス禁止領域を特定します。

- Allowルールも同時に確認し、許可されている範囲を明確化します。

API提供状況を確認する

一部のウェブサイトでは、公式APIを提供しており、これがスクレイピングの代替手段となります。API使用の有無によって対応策を考えることが可能です。

- ウェブサイト内で「Developer」や「API」などに関連するページを探します。

- API利用規約や制限事項を確認し、公式に許可されたデータ取得方法かどうか判断します。

- APIキーの申請が必要な場合は、指示に従って手続きを進めることが重要です。

パイソンのビューティフルスープとは?

パイソンのビューティフルスープ(Beautiful Soup)は、Pythonで使用される強力なライブラリであり、HTMLやXML文書を解析し、データを抽出するためのツールです。このライブラリは主にウェブスクレイピングに利用され、複雑な構造を持つウェブページから特定の情報を効率的に取得することができます。

ビューティフルスープの基本機能

ビューティフルスープはHTML/XML解析において非常に柔軟性があり、壊れたマークアップであっても修復しながら解析します。以下はその主な特徴です。

- パーサーのサポート: 内部ではlxmlやhtml.parserなど複数のパーサーに対応しており、状況に応じて最適なものを選択できます。

- タグ検索: findやfind_allメソッドを使用して、指定したタグや属性に基づいてデータを効率的に検索可能です。

- ナビゲーション機能: タグ間を移動したり、親子関係にある要素を簡単にたどることができます。

ビューティフルスープを使ったウェブスクレイピング例

実際にウェブサイトから情報を取得する際には、ビューティフルスープとrequestsモジュールを組み合わせることが一般的です。以下は代表的なステップです。

- データ取得: requests.get()を使用してウェブページのHTMLソースを取得します。

- パース処理: 取得したHTMLをBeautifulSoupオブジェクトに渡し、解析を行います。

- データ抽出: 特定のタグやクラス名を指定して必要なテキストやリンクなどを抽出します。

ビューティフルスープの活用事例

ビューティフルスープは多岐にわたる分野でデータ収集や分析に役立ちます。具体的なユースケースを挙げると以下のようになります。

- 価格監視: オンラインショップの商品価格を定期的に収集し、変動を追跡します。

- ニュース集約: 複数のニュースサイトから記事タイトルや内容を自動的に取得します。

- 学術研究: ウェブ上の公開データを基に統計分析やトレンド調査を行います。

よくある質問

PythonでHTMLを読み込む方法は?

PythonでHTMLを読み込むには、主に「requests」や「urllib」といったライブラリを使用します。これらのライブラリは、指定したWebページのデータを取得するための強力なツールです。「requests」はシンプルで使いやすく、GETリクエストを送信してHTMLコンテンツを取得することが一般的です。例えば、「response = requests.get(url)」のように記述し、レスポンスオブジェクトからHTMLデータを取り出せます。一方、「urllib」は標準ライブラリであり、追加インストールが不要ですが、少し冗長になる場合があります。どちらを使う場合でも、取得したHTMLデータを解析するにはBeautifulSoupのようなパッケージと組み合わせると効果的です。

HTMLデータをどのように解析すればいいですか?

HTMLデータを解析する際には、BeautifulSoupというライブラリが非常に役立ちます。このライブラリを使えば、HTMLタグや属性に基づいて必要な情報を簡単に抽出できます。たとえば、特定のクラス名やIDを持つ要素を検索するために「find」や「find all」メソッドを使用します。これにより、目的のデータをピンポイントで取得可能です。また、HTML構造が複雑な場合でも、階層的な探索やCSSセレクターを利用することで効率的に処理を行えます。さらに、正規表現を併用することで、より柔軟な条件でのデータ抽出も可能になります。重要なのは、対象となるHTMLの構造を理解し、適切なメソッドを選ぶことです。

取得したWebページのデータをどのように活用できますか?

取得したWebページのデータは多岐にわたる用途で活用できます。例えば、ニュースサイトから記事内容を収集してテキスト分析を行うことができます。また、Eコマースサイトの商品情報を取得し、価格比較ツールを開発することも可能です。他にも、SNSの投稿を収集してトレンド分析を行ったり、APIがないサイトからデータセットを作成したりと、幅広い応用が考えられます。ただし、利用する際には著作権や利用規約に十分注意する必要があります。特に、スクレイピング行為が禁止されている場合や、過度な負荷をかけるアクセスは避けるべきです。また、収集したデータを保存・加工する際には、データベースやCSVファイルなどを活用すると便利です。

Webページの動的なコンテンツに対応するにはどうすればよいですか?

動的なコンテンツを含むWebページの場合、単純にHTMLを読み込むだけでは不十分なことがあります。このようなケースでは、JavaScriptによって生成されるコンテンツを扱う必要があります。そのために使用されるのがSeleniumやPlaywrightといったツールです。これらはブラウザを自動操作する仕組みを持っており、JavaScriptを実行した後の結果を取得できます。例えば、Seleniumではヘッドレスブラウザモードを利用してバックグラウンドでページをレンダリングし、完全にロードされた状態のHTMLを取得可能です。ただし、これらのツールは比較的リソースを多く消費するため、大規模なーリングには向かないこともあります。そのため、必要に応じてキャッシュ機能や非同期処理を導入し、効率化を図ることが推奨されます。