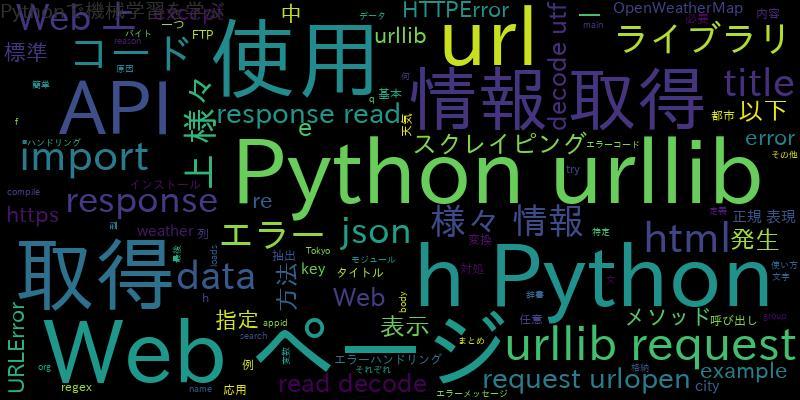

🌐 PythonでURLを取得する様々なテクニック

Pythonは、Web開発やデータ処理において非常に強力なツールであり、URLの取得や操作も例外ではありません。本記事では、Pythonを使用してURLを効率的に取得するための様々なテクニックについて解説します。標準ライブラリからサードパーティ製のパッケージまで、初心者から上級者まで役立つ手法を取り上げます。具体的には、`urllib`や`requests`を活用した基本的な方法から、スクレイピングやAPIとの連携による高度な手法まで幅広くカバーします。これらのスキルを身につけることで、Web上の情報を効果的に収集し、プロジェクトに役立てることができるでしょう。それでは、各テクニックを見ていきましょう。

🌐 PythonでURLを取得する様々なテクニックの概要

Pythonを使用してURLを取得する方法は、現代のWeb開発やデータ分析において重要なスキルです。この記事では、そのために利用可能な手法やライブラリについて解説します。

1. requestsライブラリを活用した基本的なURL取得方法

- requests.get()関数を使用して、指定されたURLからレスポンスを取得します。この関数はシンプルで使いやすく、HTTPステータスコードも確認可能です。

- レスポンスオブジェクトからtextまたはcontent属性を使用することで、HTMLソースコードなどを抽出できます。

- カスタムヘッダーやタイムアウト設定を追加することで、より柔軟なリクエストが可能になります。

2. BeautifulSoupと組み合わせたスクレイピング手法

- BeautifulSoupは、HTMLやXML文書を解析するための強力なツールです。requestsライブラリと併用することで、ターゲットページ内のリンクを簡単に抽出できます。

- find all()メソッドを使ってタグを検索し、href属性を取得することが一般的です。

- 不要な要素をフィルタリングするために、正規表現や特定の条件を適用できます。

3. urllibモジュールを使った標準ライブラリでのアプローチ

- Pythonの標準ライブラリであるurllib.requestを使用すると、外部ライブラリに依存せずにURLを取得できます。

- urlopen()関数により、HTTPレスポンスを受け取り、read()メソッドでコンテンツを取得します。

- ただし、複雑な操作には向いておらず、エラーハンドリングも自前で実装する必要があります。

4. APIからのURL取得とjsonデータの解析

- 多くのWebサービスはAPIを提供しており、そこからJSON形式でデータを取得できます。

- requests.get()でAPIエンドポイントを叩き、response.json()メソッドを利用してデータをパースします。

- 得られたデータの中から、目的のURLを含むキーを探し出し、それをプログラム内で使用します。

5. Seleniumによる動的ページからのURL取得

- Seleniumは、JavaScriptで生成される動的なコンテンツを扱う際に非常に有用です。

- WebDriverを使用してブラウザを自動操作し、ページ遷移やボタンクリック後に表示されるリンクを取得します。

- 非同期処理に対応しているため、Ajaxベースのサイトでも安定して情報を抽出可能です。

PythonでWebサイトにアクセスするにはどうすればいいですか?

PythonでWebサイトにアクセスするには、主に requests ライブラリや urllib を使用します。以下の手順に従ってアクセスできます。

1. requestsライブラリの使い方

requests は最も一般的なHTTPライブラリであり、シンプルなコードでWebサイトにアクセスできます。以下はその主な手順です。

- インストール: `pip install requests` コマンドを使用してライブラリをインストールします。

- GETリクエスト: `requests.get(url)` を使って目的のURLにアクセスし、レスポンスを取得します。

- ステータス確認: `.status_code` を利用してHTTPステータスコードを確認し、成功したかチェックします。

2. urllibを使った基本的なアクセス方法

urllib は標準ライブラリなので追加インストールが不要で、シンプルな用途に向いています。以下の点を押さえて使用します。

- インポート: `from urllib.request import urlopen` から必要なモジュールを読み込みます。

- データ取得: `urlopen(url).read()` を実行することでHTMLやデータを取得可能です。

- エラーハンドリング: try-except構文を用いて接続エラーなどの例外処理を行います。

3. Webスクレイピングと解析の連携

Webサイトにアクセス後、情報を解析するために BeautifulSoup などのツールと組み合わせると効果的です。

- HTML解析: 取得したHTMLをパースするために `BeautifulSoup(response.text, ‘html.parser’)` を使用します。

- 要素抽出: 特定のタグやクラス名を指定して `find_all()` などでデータを抜き出します。

- データ保存: 抽出した情報をCSVやJSON形式でローカルに保存し、再利用可能にします。

Pythonのスクレイピングとは?

Pythonのスクレイピングとは、Webサイトからデータを自動的に抽出するプロセスを指します。この技術は、Pythonというプログラミング言語とその関連ライブラリ(例: BeautifulSoupやSelenium)を使用して、HTMLやXML形式で記述されたWebページから特定の情報を取得することを目的としています。これにより、大量のデータを手作業で収集する手間を省き、効率的なデータ分析や処理が可能になります。

Pythonのスクレイピングで使用される主なツール

Pythonでのスクレイピングには、いくつかの重要なツールやライブラリが使用されます。以下は代表的なものです。

- BeautifulSoup: HTMLやXMLファイルを解析し、必要なデータを簡単に抽出できるライブラリです。

- Requests: WebサイトにHTTPリクエストを送信し、レスポンスを取得するためのシンプルなライブラリです。

- Selenium: 動的コンテンツやJavaScriptで生成された要素に対応するために使用される強力なツールです。

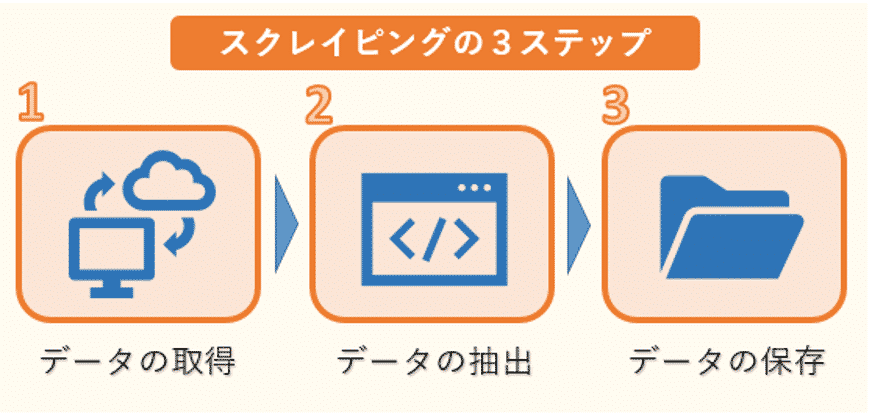

スクレイピングの具体的な手順

スクレイピングを行う際には、一般的に以下の手順が採用されます。

- ターゲットとなるWebサイトを特定し、その構造を確認します。

- HTMLコードから必要な部分を解析し、データを抽出するためのプログラムを作成します。

- 得られたデータをCSVやJSONなどの形式で保存し、後続の分析や処理を行います。

スクレイピングの注意点と法的問題

スクレイピングを行う際には、いくつかの倫理的および法的な考慮が必要です。

- Webサイトの利用規約を確認し、スクレイピングが許可されているかを事前に調べる必要があります。

- サーバーに過剰な負荷を与えないよう、適切な間隔を空けてリクエストを送信することが推奨されます。

- 個人情報や著作権で保護されたデータを無断で収集することは避けるべきです。

Urllibとは何ですか?

Urllibは、Pythonの標準ライブラリに含まれるモジュールであり、URLを扱うためのさまざまな機能を提供します。このモジュールは主にWeb上のリソースとやり取りするためのツール群で構成されており、HTTPやFTPプロトコルを介してデータを取得したり操作したりするのに使用されます。

Urllibの主要なコンポーネント

Urllibはいくつかのサブモジュールに分かれており、それぞれが特定の目的のために設計されています。以下は主要なコンポーネントです。

- urllib.request: URLからリソースを取得するために使用されるモジュールです。例えば、Webページをダウンロードする際に利用されます。

- urllib.parse: URL文字列を解析・操作するためのツールを提供します。これにより、クエリパラメータの分解やエンコードが可能です。

- urllib.error: urllib.requestでの例外処理をサポートし、エラーをキャッチして適切に対応する手段を提供します。

Urllibを使用する利点

Urllibを使うことで得られる主な利点について説明します。

- Pythonの標準ライブラリに含まれているため、追加のインストール作業が不要で簡単に利用できます。

- 柔軟性があり、複雑なリクエスト(認証やヘッダーのカスタマイズなど)にも対応可能です。

- 広範囲なプロトコル(HTTP、HTTPS、FTPなど)をサポートしているため、多様な用途に活用できます。

Urllibの一般的な用途

Urllibは次のような用途で頻繁に使用されます。

- WebサイトやAPIからのデータ収集(例: スクレイピングやデータ取得)。

- URLのクエリ文字列を動的に生成したり、変更したりするシナリオ。

- 自動化されたテストやシステム監視でHTTPリクエストをシミュレートするタスク。

Webスクレイピングの使い方は?

Webスクレイピングの使い方は、主にデータ収集や分析、自動化を目的としています。これにより、ウェブサイト上の公開情報を効率的に取得し、さまざまな用途で活用できます。

1. データ収集と市場調査

市場動向や競合他社の情報を収集するために、Webスクレイピングは非常に効果的です。例えば、価格比較サイトでは、商品の価格データを定期的に取得して最新情報を提供します。

- 競合分析: 競合サイトの製品情報や価格設定を確認し、戦略立案に役立てる。

- 消費者レビュー: 複数サイトからレビューを収集し、顧客満足度の傾向を把握する。

- 需要予測: キーワード検索ボリュームやトレンドデータを利用して、将来の需要を予測する。

2. 自動化による業務効率化

Webスクレイピングを使用することで、手動でのデータ収集作業を自動化でき、大幅な時間短縮が可能です。特に、反復的なタスクが多い業務ではその効果が顕著です。

- フォーム入力自動化: 決まったフォーマットのデータを複数のサイトに自動送信する。

- 在庫管理: サプライヤーのサイトからリアルタイムで在庫状況を取得し、不足を防ぐ。

- コンテンツ更新監視: 特定サイトの変更点を監視し、更新があった場合に通知を受け取る。

3. 学術研究とデータ分析

学術分野では、Webスクレイピングを用いて大量のデータセットを収集し、それを元に統計解析や機械学習モデルを構築することが一般的です。

- ソーシャルメディア分析: TwitterやFacebookなどから投稿データを収集し、感情分析を行う。

- オープンデータ利用: 政府や公共機関のサイトからオープンデータを抽出し、可視化する。

- 言語処理研究: Webページからテキストデータを収集し、自然言語処理のアルゴリズム開発に活用する。

よくある質問

PythonでURLを取得する方法は何がありますか?

Pythonでは、requests ライブラリや urllib モジュールを使用してURLのデータを取得できます。requestsはシンプルで直感的なAPIを持つため、HTTPリクエストを送信する際に広く使用されています。一方、urllibは標準ライブラリに含まれており、外部依存が不要です。さらに、BeautifulSoup や lxml といったパッケージを組み合わせれば、HTMLやXMLの解析も容易に行えます。これにより、ウェブスクレイピングやAPIからの情報を簡単に収集できます。

requestsとurllibの違いは何ですか?

requests は外部ライブラリであり、使いやすく設計されているため、開発者にとって学習コストが低いのが特徴です。たとえば、GETリクエストを行う場合、数行のコードで済みます。対して、urllib はPythonの標準ライブラリに含まれているため、追加インストールが不要です。ただし、urllibはやや冗長なコードが必要になる場合があり、requestsほどの直感的なインターフェースではありません。それぞれの用途やプロジェクト要件によって適切な方を選択することが重要です。

どのようにしてPythonでURLからデータを安全に取得しますか?

URLからデータを安全に取得するためには、SSL証明書の検証を行うことが重要です。requests.get() を使用する際、デフォルトでSSL証明書の検証が有効になっています。これを無効にする場合はverify=Falseを指定できますが、セキュリティリスクがあるため推奨されません。また、try-except ブロックを使用して例外処理を行うことで、接続エラーやタイムアウトなどの問題に対応できます。さらに、headers をカスタマイズすることで、正当なリクエストであることをサーバーに示すことも可能です。

PythonでURLからファイルをダウンロードする方法は何ですか?

requests ライブラリを使用してURLからファイルをダウンロードする場合、stream=Trueオプションを設定し、レスポンスの内容をチャンク単位で処理できます。これにより、大容量のファイルでもメモリを効率的に使用できます。次に、open() 関数を使用してローカルファイルを作成し、レスポンスデータを書き込みます。また、shutil.copyfileobj() を利用すると、さらに効率的にファイルを保存できます。この手法は、画像、PDF、動画などさまざまな形式のファイルに適用可能です。