🕷️ Python スクレイピング selenium でWebデータを自動収集!

現代のデータ駆動型社会において、Web上の情報を効率的に収集することは重要な課題です。Pythonのスクレイピング技術は、この問題を解決する強力な手段として注目されています。特にSeleniumを活用することで、動的なWebサイトからデータを自動で抽出することが可能になります。本記事では、Seleniumを用いたPythonスクレイピングの基本的な手順や実践的なテクニックについて解説します。これにより、複雑なWebページでも柔軟に対応し、目的のデータを効率的に取得する方法を学ぶことができます。ぜひこの機会に、自動化の可能性を広げるスキルを身につけましょう。

PythonとSeleniumを活用したWebデータ自動収集の完全ガイド

PythonとSeleniumを使用することで、効率的かつ正確にWebデータを自動収集することが可能です。この記事では、その方法や具体的なステップについて詳しく説明します。

1. Seleniumとは?その基本的な仕組み

Seleniumは、主にWebブラウザを操作するためのツールです。

- Selenium WebDriverは、ブラウザをプログラムで制御できる機能を提供します。

- 主にスブラウザテストやスクレイピングに利用されます。

- ChromeやFirefoxなど、主要なブラウザに対応しています。

2. PythonでSeleniumを導入する手順

Python環境でSeleniumを使用するにはいくつかの準備が必要です。

- Seleniumライブラリをpipコマンドでインストールします(例: pip install selenium)。

- 対象ブラウザのWebDriverを公式サイトからダウンロードします。

- コード内でimport seleniumを行い、ブラウザを起動する設定を行います。

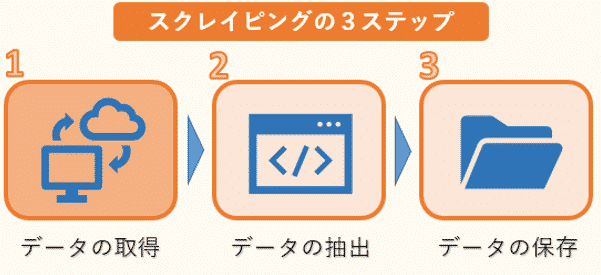

3. Webページからデータを取得する方法

Webページ上の情報を抽出する際には特定の要素を指定する必要があります。

- XPathやCSSセレクタを利用して、HTML要素を特定します。

- find elementメソッドを使い、テキストや属性値を取得します。

- 繰り返し処理を活用して大量のデータを一括取得できます。

4. よくあるエラーと解決策

Seleniumを使った自動化では、様々な問題が発生することがあります。

- タイムアウトエラーは、要素の読み込み待ち時間を調整することで解決できます。

- JavaScriptによる動的なコンテンツは、明示的に待機処理を追加する必要があります。

- ブラウザバージョンとWebDriverの不一致を防ぐために、常に最新版を使用しましょう。

5. スクレイピングにおける倫理と法的注意点

Webデータの収集には倫理的および法的な配慮が必要です。

- Robots.txtファイルを確認し、ーリングが許可されているか確認します。

- 過剰なアクセスはサーバー負荷を増大させるため、適切な間隔を設けましょう。

- 個人情報や著作権のあるデータの利用には特別な注意が必要です。

スクレイピングはなぜ禁止されているのですか?

1. サーバー負荷の増加

サーバー負荷が増えることは、多くのウェブサイトがスクレイピングを禁止する主な理由の一つです。大量のデータを自動的に収集しようとすると、サーバーに過度なリクエストが集中し、通常のユーザーが利用しづらくなる可能性があります。

- 短時間での多数のアクセスにより、サーバーダウンのリスクが高まる。

- 帯域幅の過剰消費で、運営コストが増大する。

- 正当な利用者が遅延や障害を体験する可能性がある。

2. 個人情報保護とプライバシー侵害

個人情報やプライバシーに関する懸念もスクレイピングが禁止される大きな要因です。特定の手法によっては、意図せずとも機密性の高い情報を取得してしまうことがあります。

- 不正利用につながるリスクが高まり、法的問題を引き起こす。

- ユーザーの同意なしにデータが収集されると倫理的な問題が生じる。

- 一部のサイトではセキュリティ対策が不足しており、漏洩の危険性がある。

3. コンテンツの不正使用

コンテンツの著作権を侵害する行為もまた、スクレイピングを禁止する重要な理由です。サイトの内容を無断で複製・再利用することは、クリエイターの権利を損なう行為です。

- 無許可の転載により、オリジナルコンテンツの価値が下がる。

- 広告収益やビジネスモデルに悪影響を与えることがある。

- 独自性のあるデータが競合他社に渡ることで市場競争が歪む。

Seleniumとはスクレイピングで何ですか?

Seleniumは、主にウェブアプリケーションのテスト自動化のために設計されたツールですが、スクレイピングにおいても強力な役割を果たします。このツールを使用することで、動的なウェブサイト(JavaScriptでレンダリングされるコンテンツなど)からデータを抽出することが可能になります。Seleniumはブラウザをプログラムで操作できるため、人間が実際にウェブサイトを閲覧しているかのように動作し、複雑なウェブページでも正確にデータを取得できます。

Seleniumの基本的な仕組み

Seleniumはどのようにしてスクレイピングを実現するのでしょうか?その仕組みについて説明します。

- ブラウザ制御: Seleniumは、ChromeやFirefoxなどのブラウザを直接制御します。これにより、動的コンテンツを含むページでも、完全にロードされた状態で情報を取得できます。

- WebDriver: WebDriverと呼ばれるインターフェースを通じて、各ブラウザの動作をプログラムから指示できます。この仕組みがSeleniumの核です。

- DOM操作: HTML要素やJavaScriptの実行結果を解析し、目的のデータを特定して抽出します。

Seleniumを使ったスクレイピングの利点

Seleniumを使うことで得られる具体的なメリットは何でしょうか?以下に詳しく説明します。

- 動的ページ対応: JavaScriptによって生成される動的なコンテンツに対しても、問題なくデータを取得できます。

- 柔軟性: 複数のブラウザやOS環境での実行が可能です。そのため、スブラウザテストにも応用できます。

- 豊富なアクション: マウスクリックやキーボード入力などの高度な操作が可能であり、より複雑なスクレイピングタスクを実現できます。

Seleniumの課題と代替手段

Seleniumにはどのような課題があり、他の選択肢と比較するとどう評価されるのでしょうか?以下のポイントに注目してください。

- パフォーマンス: 実際のブラウザを起動するため、リソース消費が多くなります。この点では、RequestsやBeautifulSoupなどの軽量なライブラリの方が効率的です。

- 学習コスト: 初心者にとって、設定や使い方が少し複雑に感じる場合があります。

- 代替ツール: PuppeteerやPlaywrightのような新しいツールも登場しており、より高速でモダンなアプローチを提供しています。

Pythonスクレイピングの注意点は?

Pythonスクレイピングの注意点は、データ取得における法律や倫理、技術的な課題を理解し、適切に対処することです。以下にその詳細を説明します。

1. 法的制約と利用規約への準拠

ウェブサイトの利用規約や法律(例:著作権法、個人情報保護法)を遵守することは最重要です。適切な対応を怠ると法的トラブルに発展する可能性があります。

- robots.txtファイルを確認し、ーリングが許可されている範囲を把握する。

- サイトの利用規約を精査し、特にデータの二次利用に関する制限を理解する。

- 必要に応じて、該当のウェブサイト運営者に事前許可を得る。

2. サーバー負荷を最小化する配慮

頻繁かつ大量のリクエストは、ターゲットサーバーに過負荷を与え、サービスの妨害につながる可能性があります。

- リクエスト間隔を空けるためにtime.sleep()を使用し、負荷を分散させる。

- 必要なデータのみを効率的に収集し、無駄なリクエストを避ける。

- APIが提供されている場合は、そちらを優先利用する。

3. データの正確性と一貫性の確保

HTML構造の変更や動的コンテンツの扱いにより、取得したデータの品質が低下するリスクがあります。

- 定期的にスクリプトを見直し、サイトデザイン変更に合わせて更新を行う。

- JavaScriptで生成されるコンテンツにはSeleniumなどのツールを使用して対応する。

- 収集したデータに対して検証プロセスを導入し、不備がないか確認する。

Googleのスクレイピングは違法ですか?

Googleのスクレイピングは、その目的や方法によって違法になる可能性があります。Googleの利用規約では、自動化された手段によるコンテンツの大量収集が明確に禁止されています。そのため、利用規約に違反する形でスクレイピングを行うと違法行為とみなされる場合があります。ただし、合法的な理由があり、対象となるデータの使用が適切であれば、問題なく実施できるケースもあります。

Googleの利用規約とスクレイピング

Googleの利用規約には、ユーザーが自動化ツールを使用してサービスを不正利用することを制限する条項があります。

- 利用規約への準拠:Googleの利用規約では、ーリングやスクレイピングを過剰に行うことが禁止されています。

- 許可された範囲での利用:APIを通じて提供される情報を取得する場合は、規約内で認められる場合があります。

- 違反時のリスク:規約違反の場合、法的措置やアカウントの停止といったペナルティが課されることがあります。

スクレイピングの法律上の位置付け

スクレイピング自体が直接的に違法というわけではありませんが、具体的な状況次第で違法性が問われるケースがあります。

- 著作権侵害:Googleのコンテンツが著作物である場合、無断での複製や再配布は法律違反となります。

- 個人情報保護:スクレイピングによって個人情報が含まれるデータを取得すると、プライバシー侵害の問題が生じます。

- 競争法との関係:他社のビジネスモデルを損なう意図でデータを収集すると、不正競争防止法に抵触する恐れがあります。

合法的なスクレイピングの例

一部のケースでは、Googleのデータを合法的に取得し活用することが可能です。

- 公開データの活用:Googleから提供されている公開情報であり、規約内に従った形での利用は認められることが多いです。

- 研究目的での利用:学術研究などの公益目的で行われるスクレイピングは、一定条件下で合法性が確保される場合があります。

- 公式APIの使用:Googleが提供している公式APIを利用することで、安全かつ効率的に必要な情報を得ることが可能です。

よくある質問

PythonでSeleniumを使う際のインストール方法は?

Selenium を使用するには、まずPython環境が整っている必要があります。その後、ターミナルまたはコマンドプロンプトからpip install seleniumというコマンドを実行することで簡単にインストールできます。また、ブラウザに対応したWebDriverも必要ですので、ChromeならChromeDriver、FirefoxならGeckoDriverを公式サイトからダウンロードして適切な場所に配置してください。バージョンの互換性にも注意し、ブラウザとWebDriverのバージョンを一致させることが重要です。

Seleniumでスクレイピングする際の基本的なコード構成は?

Seleniumを使ったWebデータ収集では、まずwebdriverモジュールをインポートします。次にWebDriverオブジェクトを作成し、目的のURLへアクセスします。例えば、driver.get(https://example.com) のように指定します。そして、find elementやfind elementsメソッドを利用してHTML要素を特定し、テキストや属性を抽出します。最後に、作業が終わったら必ずdriver.quit()を呼び出してセッションを終了することが推奨されます。これによりリソースの解放がスムーズに行われます。

動的なコンテンツをスクレイピングするにはどうすればいいですか?

動的なJavaScriptベースのコンテンツをスクレイピングするには、ページの完全な読み込みを待つ必要があります。Seleniumにはそのためのexplicit waitやimplicit waitといった待機機能があります。たとえば、WebDriverWaitとexpected conditionsを組み合わせることで、特定の要素が表示されるまでプログラムを待機させることができます。これにより、ページが途中でロードされず必要なデータが取得できないという問題を回避できます。ただし、無駄な待機時間を減らすために、適切なタイムアウト設定を行うことが重要です。

スクレイピングで発生しうるエラーへの対処法は?

スクレイピング中にNoSuchElementExceptionやTimeoutExceptionなどのエラーが発生することがあります。このような場合、まずは要素のセレクタが正しいか確認してください。変更されたHTML構造やスペルミスが原因であることが多いです。また、ウェブサイト側のボット対策によってブロックされることもありますので、アクセス間隔を調整したり、User-Agentをカスタマイズしたりすると有効です。それでも解決しない場合は、エラーログを詳しく解析し、必要に応じてtry-exceptブロックを使用して例外処理を実装してください。